Это очередное напоминание о том, что чат-боты на базе искусственного интеллекта по-прежнему выдумывают и лгут с той же уверенностью, что и система GPS, сообщающая вам, что самый короткий путь домой — проехать через озеро.

Данное напоминание предоставлено лабораторией Nieman Lab, которая провела эксперимент, чтобы проверить, будет ли ChatGPT выдавать правильные ссылки на статьи из новостных изданий, которым она платит миллионы долларов. Оказывается - нет. Вместо этого он уверенно составляет целые фейковые URL-адреса — явление, которое в индустрии искусственного интеллекта называют «галлюцинацией» — термин, который кажется более подходящим для реального человека, погруженного в свою чушь.

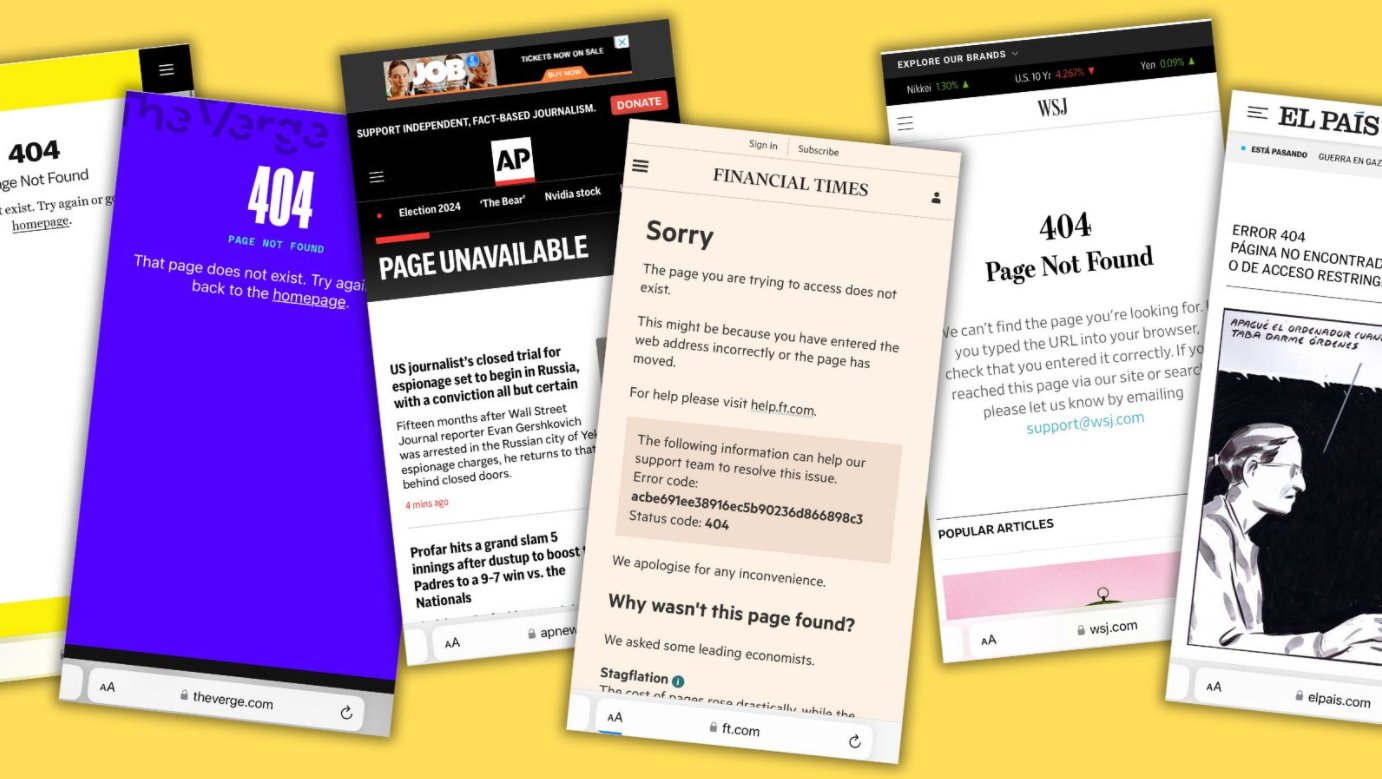

Эндрю Дек из Nieman Lab попросил сервис предоставить ссылки на громкие эксклюзивные истории, опубликованные 10 издателями, с которыми OpenAI заключила сделки на миллионы долларов. В их число входили Associated Press, The Wall Street Journal, Financial Times, The Times (Великобритания), Le Monde, El País, The Atlantic, The Verge, Vox и Politico. В ответ ChatGPT выдал вымышленные URL-адреса, которые привели к страницам с ошибками 404, поскольку их просто не существовало. Другими словами, система работала именно так, как задумано: предсказывала наиболее вероятную версию URL-адреса истории вместо того, чтобы фактически ссылаться на правильный. Лаборатория Нимана провела аналогичный эксперимент с единственным изданием — Business Insider — ранее в этом месяце и получила тот же результат.

Представитель OpenAI сообщил Nieman Lab, что компания все еще создает «опыт, который сочетает в себе диалоговые возможности с их последним новостным контентом, обеспечивая правильную атрибуцию и ссылки на исходный материал — расширенный опыт, который все еще находится в разработке и еще не доступен в ChatGPT». Но они отказались объяснить фальшивые URL-адреса.

Мы не знаем, когда этот новый опыт станет доступен и насколько он будет надежным. Несмотря на это, издатели новостей продолжают вкладывать годы журналистики в зияющую пасть OpenAI в обмен на холодные и твердые деньги, потому что журналистская индустрия постоянно терпит неудачу в понимании того, как зарабатывать деньги, не продавая свою душу технологическим компаниям. Между тем, компании, занимающиеся искусственным интеллектом, отказываются от контента, публикуемого всеми, кто не подписал эти фаустовские соглашения, и все равно используют его для обучения своих моделей. Мустафа Сулейман, глава Microsoft по искусственному интеллекту, недавно назвал все, опубликованное в Интернете, «бесплатным программным обеспечением», которое является честной игрой для обучения моделей искусственного интеллекта. На момент написания этой статьи стоимость Microsoft оценивалась в 3,36 триллиона долларов.

И отсюда можно сделать простой вывод: если ChatGPT выдумывает URL-адреса, он также выдумывает и факты. Именно так работает генеративный ИИ: по своей сути эта технология представляет собой более причудливую версию автозаполнения, просто угадывающую следующее правдоподобное слово в последовательности. Он не «понимает» то, что вы говорите, хотя и действует соответствующим образом.

Иван Ковалев

VIAВосстановить утраченные данные бывает нелегко, особенно если речь идет об обыкновенном SD-накопителе. Однако с работой

На сегодняшний день, как ни крути, но оптимальным решением при постройке бюджетного домашнего кинотеатра все-таки

Как и в старших моделях в iPhone 7 mini появится кнопка Touch ID с функцией обратной связи Taptic Engine с персональной